További Laptop

-

Laptop

Teljesen meghülyültek a YouTuberek

Jött az ötlet, majd összeraktak egy notebookszörnyet: 43 hüvelykes lett a csináld-magad gamerlaptop.

-

Laptop

Nagyon menő lett az új Lenovo ThinkPad

Bemutatta új generációs ThinkPadjait a Lenovo, köztük – legalábbis a cég portfóliójában – egy ízig-vérig újdonságnak...

-

Laptop

Új notebookot hozott Magyarországra a HUAWEI

A MateBook 14 egy teljes munkanapot kibír egyetlen töltéssel

-

Laptop

Magasabb kijelzővel jöhetnek az új MacBook Pro laptopok

A jelenleginél magasabb képernyővel érkezhet a következő Apple MacBook Pro, de még nem 3:2 képaránnyal. Közeledik...

-

Laptop

Kifejezetten fiatalos lett a Huawei új laptopja

A könnyű és vékony MateBook D15 ideális a tanuláshoz, a munkához és a szórakozáshoz

-

Laptop

Új dizájnnal debütálnak az LG 2021-es Gram laptopjai

Az ultrakönnyű laptopok nagyobb képernyőfelületet és stílusos dizájnt kaptak, a megszokott teljesítmény és hordozhatóság azonban nem...

-

Laptop

Milyen laptopot vegyünk a gyereknek?

A mai gyermek kiválóan ért a modern eszközökhöz. Ráadásul az online oktatás népszerűségével számos intézmény videokonferenciákon...

-

Laptop

A HONOR MagicBook 14 laptop is érkezik Magyarországra

A Honor MagicBook sorozat 14”-es verziója nagyon könnyű, legvékonyabb pontján mindössze 15,9 milliméter, hosszú üzemidejének köszönhetően...

-

Kütyük

A legújabb ASUS ZenBook 13 és a ZenBook 14 modellek

ASUS ZenBook - a világ legvékonyabb 13,3 colos és 14 colos laptopjai teljes I/O portokkal, 10....

-

Kütyük

Így válassz laptopot – Alapszintű javaslatok

Ha a számunkra ideális laptopot keressük, megannyi kérdés merül fel: milyen legyen, melyik gyártó kínálatából válasszunk,...

-

Laptop

Megérkeztek a Huawei új notebookjai Magyarországra

A MateBook 13-mal és MateBook D 15-tel tér vissza a PC-piacra a Huawei

-

Kütyük

A felújított laptopok felülmúlják minden várakozását

Sokaknak nincs teljes elképzelésük arról, hogy mit is értünk a felújított laptopok megnevezés alatt. Ebben gyakran...

-

Laptop

Hatékonyság bárhonnan: új üzleti számítógépek a Delltől

A Dell Technologies a világ legintelligensebb és legbiztonságosabb számítógépeivel teszi hatékonyabbá a szakemberek munkáját

-

Laptop

HONOR MagicBook 15

Magyarországon is elérhető május 20-ától a Honor ultravékony, kompakt notebookja, a Honor MagicBook 15. 1,53 kg...

-

Laptop

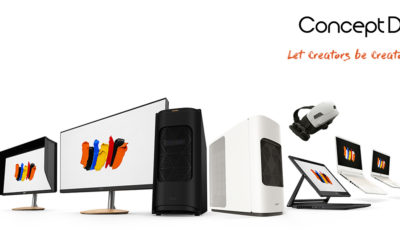

Acer ConceptD – Alkotóknak tervezve

Az Acer ConceptD termékcsalád egy egészen új világot nyit meg az amatőr és profi tartalomgyártással foglalkozók...

-

Laptop

A Huawei bemutatta a megújult MateBook X Pro-t

Az új zászlóshajó a világ leggyorsabb notebook Wi-Fi-jével és Ultra FullView kijelzővel érkezik

-

Laptop

A HP bemutatja Elite Dragonfly laptopjait

A HP ultrakönnyű prémium PC-i úttörő teljesítményt hoznak el az üzleti felhasználók számára, lenyűgöző ívelt monitoraival...

-

Laptop

Brutálisak lettek a HP új gamer laptopjai

A vállalat a V4 Future Sports Festivalon mutatja be legújabb OMEN gaming eszközeit és innovatív megoldásait

-

Laptop

Új laptopot vásárolnál? Ezekre az adatokra figyelj!

Új laptop vásárlása esetén lehetőséged van választani egy adott gép több felkínált konfigurációjából – különböző processzorral,...

-

Laptop

Mi lesz a laptopok sorsa a jövőben?

Az 5G már nem csak egy álom, közelebb van mint, valaha. Sőt több helyen már jelenleg...